Souveräne Cloud

Souveräne Cloud – was heißt das eigentlich?

Cloud-Lösungen sind aus Unternehmen kaum noch wegzudenken. Gleichzeitig wächst die Unsicherheit:

Wo liegen meine Daten? Wer hat Zugriff? Und was passiert, wenn rechtliche Rahmenbedingungen sich ändern?

In diesem Zusammenhang taucht immer häufiger der Begriff „souveräne Cloud“ auf. Doch was bedeutet „souverän“ eigentlich konkret und für wen lohnt sich dieses Cloud-Modell wirklich?

1. Was „souverän“ wirklich heißt

Der Begriff „souverän“ wird im Cloud-Kontext oft verwendet, aber selten klar definiert. Im Kern geht es nicht um eine bestimmte Technologie, sondern um Kontrolle, Transparenz und rechtliche Sicherheit.

Eine souveräne Cloud ermöglicht es Unternehmen, die volle Hoheit über ihre Daten zu behalten, unabhängig von geopolitischen, rechtlichen oder wirtschaftlichen Einflüssen externer Akteure.

Wichtig dabei:

Souveränität bedeutet nicht zwangsläufig, dass alles „on-premises“ betrieben werden muss. Vielmehr geht es um klare Zuständigkeiten, nachvollziehbare Prozesse und rechtlich saubere Rahmenbedingungen.

2. Die zentralen Kriterien einer souveränen Cloud

Ob eine Cloud-Lösung als souverän gelten kann, lässt sich anhand mehrerer Kriterien bewerten.

1. Datenhoheit

Unternehmen behalten jederzeit die Kontrolle darüber,

- wo ihre Daten gespeichert werden

- wer Zugriff hat

- wie Daten verarbeitet und gesichert werden

Weder Cloud-Anbieter noch Drittstaaten dürfen ohne Zustimmung Zugriff auf sensible Informationen erhalten.

2. Jurisdiktion

Ein zentraler Punkt ist die rechtliche Zuständigkeit.

Bei souveränen Cloud-Lösungen gilt:

- Daten unterliegen europäischem bzw. nationalem Recht

- Kein Zugriff durch außereuropäische Behörden über Gesetze wie den US CLOUD Act

- Klare vertragliche Regelungen zur Datenverarbeitung

Gerade für Unternehmen mit hohen Compliance-Anforderungen ist dieser Punkt entscheidend.

3. Betrieb und Kontrolle

Souveränität zeigt sich auch im operativen Betrieb:

- Transparente Betriebsmodelle

- Klare Rollenverteilung zwischen Anbieter und Kunde

- Möglichkeit zur eigenständigen Steuerung und Überwachung

Je nach Modell kann der Betrieb vollständig beim Anbieter liegen oder gemeinsam mit dem Unternehmen erfolgen.

3. Für wen lohnt sich eine souveräne Cloud?

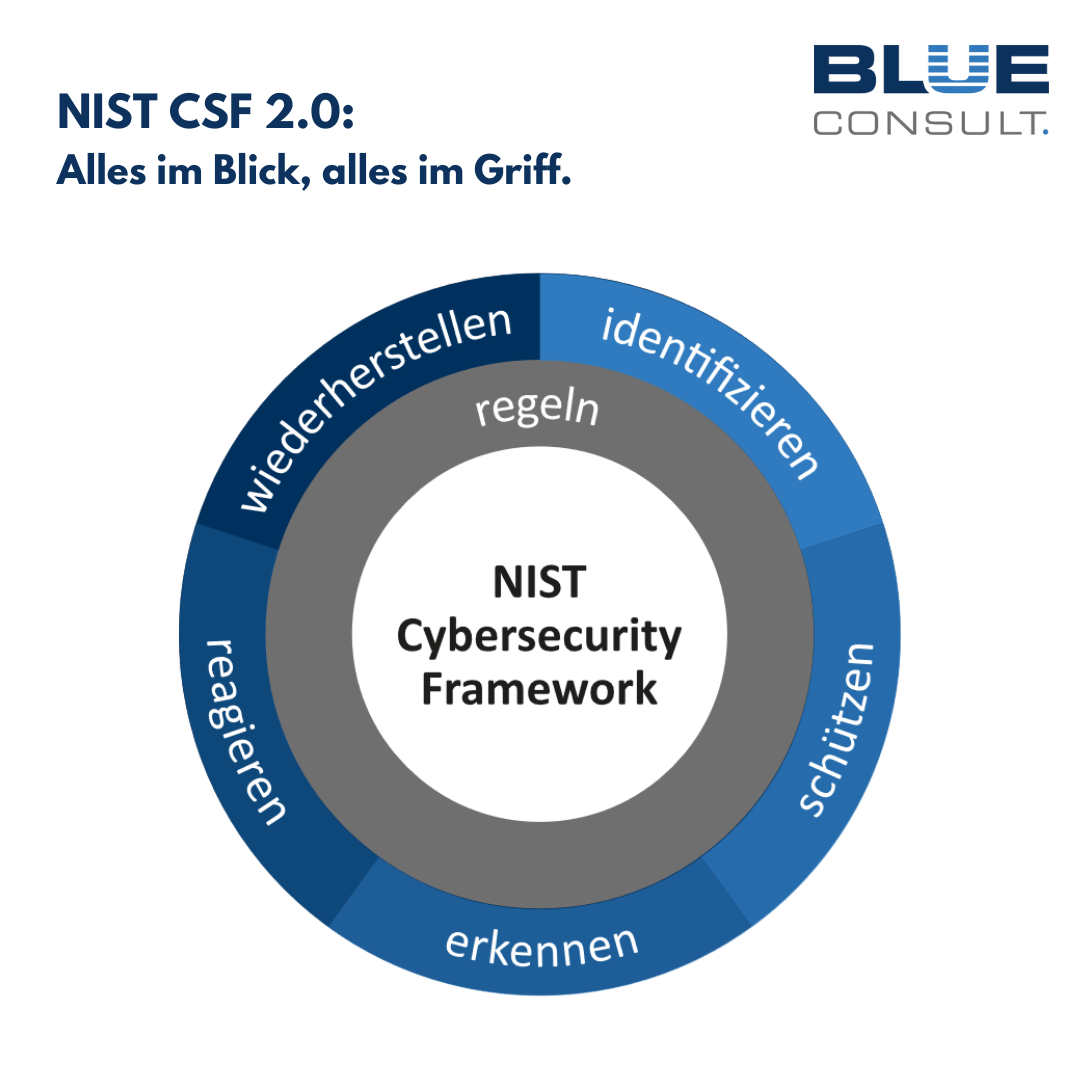

Cybersecurity bleibt ein zentraler Wachstumstreiber, wird sich jedoch bis 2026 grundlegend verändern. Die Bedrohungslage nimmt weiter zu, vor allem durch KI-gestützte Angriffe. Eine souveräne Cloud ist nicht für jedes Unternehmen zwingend erforderlich, für bestimmte Branchen und Szenarien jedoch besonders relevant

Regulierte Branchen

Unternehmen aus stark regulierten Bereichen profitieren besonders:

- Finanz- und Versicherungswesen

- Gesundheitswesen

- Kritische Infrastrukturen

- Öffentlicher Sektor

Hier sind Datenschutz, Nachvollziehbarkeit und Compliance keine Option, sondern Pflicht.

Unternehmen mit sensiblen Daten

Digitale Souveränität ist längst kein Nischenthema mehr. Die Zahl automatisierter Zugriffe durch Crawler, Bots und KI-Plattformen steigt massiv und gefährdet nicht nur Inhalte, sondern auch Datenhoheit und Compliance.

2026 rückt deshalb der Schutz eigener Daten, Texte und Geschäftsprozesse in den Fokus:

- Schutz vor Content-Scraping

- Lizenzmodelle für KI-Nutzung

- Schutz personenbezogener Daten vor KI-gestütztem Missbrauch

- Verlässliche Hosting- und Cloud-Partner

Gleichzeitig prognostiziert Gartner eine Rückverlagerung vieler Workloads in souveräne Cloud-Modelle oder regionale Rechenzentren („Geopatriation“). Bis 2030 sollen über 75 % der europäischen Unternehmen ihre Cloud-Strategie entsprechend umstellen.

Organisationen mit langfristiger IT-Strategie

Unternehmen, die ihre IT strategisch und nachhaltig ausrichten wollen, setzen zunehmend auf souveräne Cloud-Modelle. Sie ermöglichen:

- Mehr Planungssicherheit

- Geringere Abhängigkeit von Hyperscalern

- Bessere Kontrolle über zukünftige Entwicklungen

6. Souveräne Cloud ist keine Einheitslösung

Wichtig ist: Souveräne Cloud ist kein Standardprodukt, sondern ein Konzept.

Es gibt unterschiedliche Ausprägungen – von europäischen Cloud-Anbietern über hybride Modelle bis hin zu individuell betriebenen Plattformen.

Entscheidend ist nicht das Label, sondern die Frage:

Passt das Cloud-Modell zu den rechtlichen, organisatorischen und strategischen Anforderungen des Unternehmens?

7. Fazit: Souveränität schafft Handlungsspielraum

Eine souveräne Cloud bedeutet vor allem eines: Handlungsfreiheit.

Unternehmen behalten die Kontrolle über ihre Daten, erfüllen regulatorische Anforderungen und reduzieren strategische Abhängigkeiten.

Gleichzeitig erfordert dieses Modell eine bewusste Entscheidung. Souveränität entsteht nicht automatisch, sondern durch klare Anforderungen, passende Partner und eine saubere Architektur.

Wer Cloud souverän denkt, denkt nicht nur an Technik, sondern an Verantwortung, Sicherheit und Zukunftsfähigkeit.